Jeg må krybe til korset og indrømme at jeg er ikke udvikler længere, og derfor er der rigtig mange af de emner som jeg engang syntes var enormt spændende ved Goto der ikke rigtig fanger længere. Derfor var jeg glad for at se der var et deep learning spor som handler om ting jeg bruger tid på nu, nemlig data science.

Specielt syntes jeg at det var spændende at høre om the aarhusianske firma Unsilo (præsenteret af Mads Rydahl i hans presentation Discovering similar Research Ideas using Semantic Vectors and Machine Learning), som laver en recommender for videnskablige artikler. Det der gør lige netop deres problem interessant er at de også skal finde ny forskning som folk ikke nødvendigvis har koblet til den artikel de kigger på.

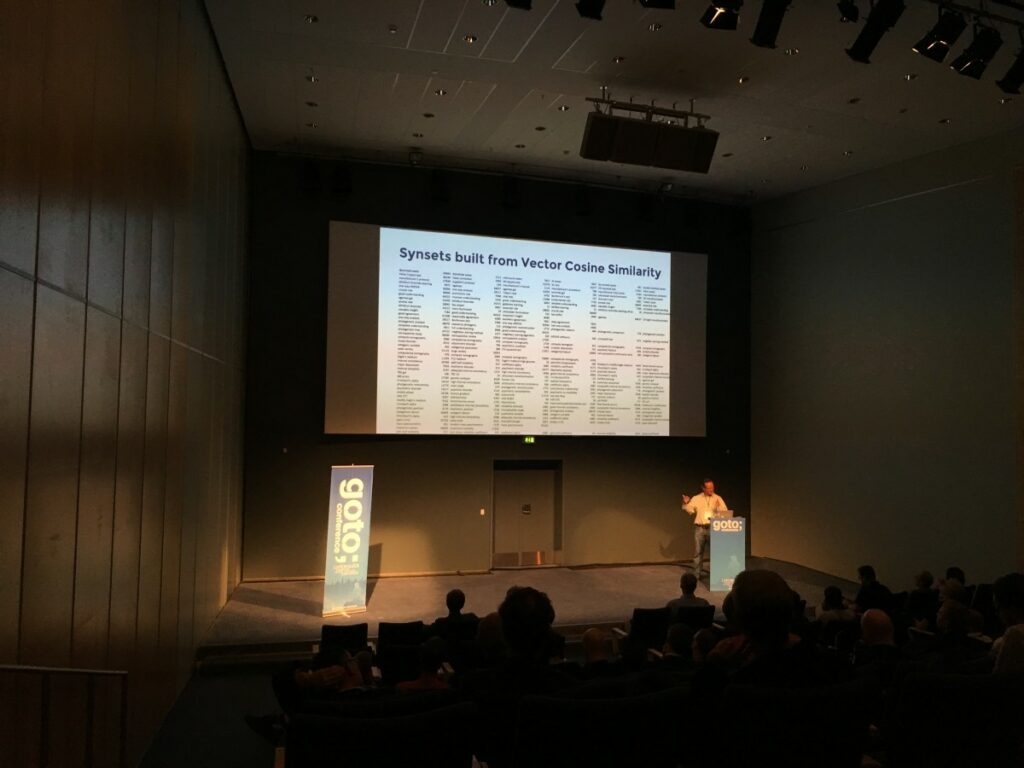

Måden de har gjort det på, (så vidt jeg forstod) var at de havde lavet en semantisk graf således at de kobler ord og sætninger med samme mening sammen. Det løser problemet som man falder igennem på når man søger på en sætning.

De snakker om en have en corpus-based recommender, som ifølge dem ikke er det samme som en traditionel recommender, men så vidt jeg kan forstå så er der ikke så stor forskel på det og en content based recommender, som traditionelt ses som den ene af to måder at lave recommenders på (den anden er collaborative (du kan læse om begge i min bog))

Det jeg syntes der lød nyt og inovativt var mængeden af feature engineering som er lavet for at nå frem til links mellem artikler som på overfladen ser ud som om de handler om noget, men når du læser den noget andet.

Jeg ville ønske jeg havde deres tool i mit arbejde, hvor jeg bruger en masse tid på at lede efter videnskabelige artikler om lige præcis dette emne Recommender systems.

En af de ting som man bruger rigtig meget tid på i recommender systemer er at beregne similarity, på billedet ovenfor viser Mads nogle af de fraser som deres system beregner til at være tæt på hinanden. For os mennesker er det ret nemt at se at det faktisk passer meget godt. Men problemet er jo at hvis du har mange tusiner dokumenter så bliver du nød til at lade en computer gøre det og stole på den. Og den liste som han viser, giver så vidt jeg kan se et rigtig godt billede af at deres algoritme virker ret godt.

Hvis du er til machine learning og bor i Aarhus, så kig på deres hjemmeside, det lyder som nogle spændende problemer de prøver at løse

(sidder til hanselman’s keynote og har tåre i øjnene af at grine, så undskyld hvis der er et par stavefejl)